首页 > 快讯 一口气发了两款自研芯片,微软这是要叫板英伟达?

一口气发了两款自研芯片,微软这是要叫板英伟达?

微软自研的 AI 芯片终于来了!

就在今天凌晨,微软在 Ignite 技术大会上一口气发布了两款自研芯片 Maia 100 和 Azure Cobalt 100 。

前者是微软首款 AI 芯片,采用了台积电 5nm 工艺,专门用于大语言模型的训练和推理。

而后者,则是一款 64 位、 128 计算核心的 CPU ,为微软的通用云服务提供支持。

根据官方的说法,目前 Maia 100 已经在自家和 OpenAI 的产品上进行了测试,世超盲猜一波,有没有一种可能 GPT-4 Turbo 已经用上了 Maia 100 ?

反正微软自研芯片的消息一出,科技圈上上下下都炸开锅。

毕竟从 2019 年开始,关于微软要自研芯片的传闻就一直没有停过,特别是在谷歌、亚马逊等科技公司亲自下场自研芯片之后,大家对于微软自研芯片的关注度也是水涨船高。

这次,微软的芯片终于 " 千呼万唤始出来 " ,难道微软是想要跟英伟达干一架?

不过,那个爱穿皮衣的男人的出现,很快打消了大家的顾虑。

微软 CEO 纳德拉把老黄请上台后,俩人先是来了一波商业互吹,接着又官宣了英伟达即将在 Azure ( 微软云服务 )上推出的 AI Foundry 服务。

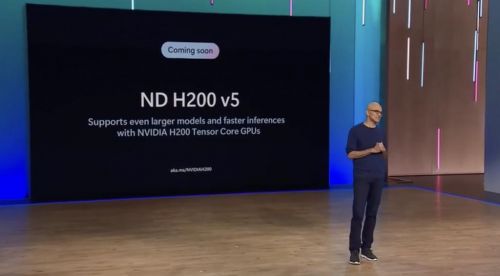

不仅如此,纳德拉也对外宣传,其实微软一直都在用英伟达的 H100 来构建 AI 超级计算机,包括 H200 出来之后,微软也准备把它加进去。

这么看来,微软其实也并没有跟芯片巨头 " 分手 " 的打算,与其说发布自研芯片是为了打破垄断,倒不如说是各路开花,给自己留条后路。

当然了,自研芯片只是大会一个小高潮,另外一场重头戏则属于 Copilot 。

说实话,整场大会听下来,我已经快被 " Copilot " 给洗脑了,甚至,纳德拉还在大会现场声称 " 微软是一家 Copilot 公司 " 。

这次大会,微软把 Bing Chat 和 Bing Chat for Enterprise 改名为 " Copilot " ,并且给 Copilot 设置了专属的域名。

这就相当于,原本 Bing Chat 只是一个内置在 Bing 搜索里的应用,现在已经独立出来了,你可以理解成微软版的 "ChatGPT" 。

改名之后, Copilot 有免费和在 Microsoft 365 里收费的两个版本。

不想花钱的朋友,现在可以直接在 Microsoft Edge 、 Google Chrome 、 Safari 上使用,只需要登录微软账号就能免费白嫖到 Dall-E 3 和 GPT-4 。

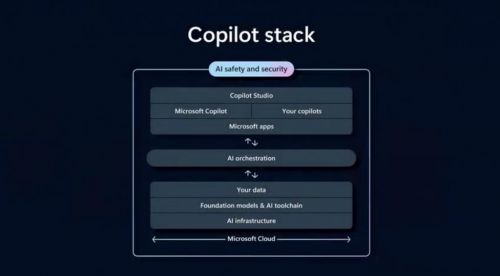

收费的版本,则多了个 Copilot Studio 低代码工具,用来自定义 Copilot 。

有点像前段时间 OpenAI 发布的 GPTs ,不同企业能用自己的数据集,来创建不同的 Copilot 。

跟 GPTs 不同的是,这里 DIY 出来的 Copilot 只适用于 Microsoft 365 ,估摸着也是为了扩展 Microsoft 365 Copilot 的生态。

打个比方,你需要一个能够帮你做财务报表,又或者能够完成绩效管理的 Copilot ,那你跟 Copilot Studio 说几句话,就直接整出个来。

在微软的愿景里, Copilot 或许就是个人计算时代的新入口。

说不定以后咱们上网啥也不需要,追剧、写论文、购物 ... 一个 Copilot 就够了。

正如纳德拉所说, " 就像我们用操作系统来访问应用程序、浏览网站一样,你可以用 Copilot 来完成这一切,甚至做更多的事情。 "

另外,除了自研芯片和 Copilot ,微软依旧在其他领域,疯狂加码 AI 。

像是基础设施方面,微软就在大会上,秀了一波自己在数据中心上下过的血本。

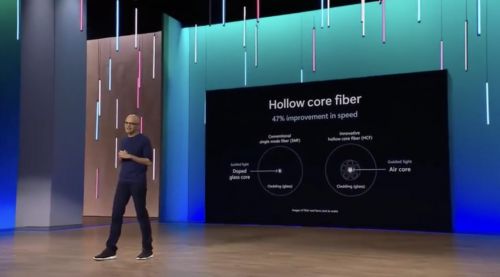

其中,微软从 2013 年开始就采购了 19GW ( 190 亿 W )的可再生能源给数据中心供电、用先进的中空芯光纤技术给数据中心的网络加速、上线 Azure Boost 系统来提高存储和网络速度等等 ...

而在基础模型上,微软也奔着从模型开发到应用落地的一条龙服务去了。

在 Azure OpenAI 服务中,开发者能用到最新的 GPT-4 Turbo ,而且还能基于 GPT-4 做微调,相当于,在 Azure 上你就能开发出一个自己的 "GPT-4" 。

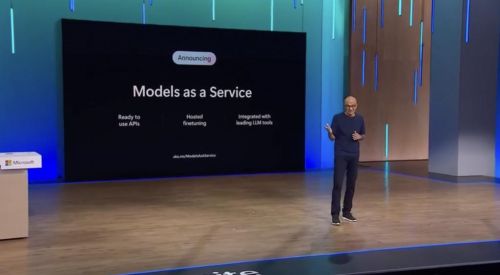

为了降低大模型开发的门槛,微软又推出了一个 " MAAS " ( Models as a Service/ 模型即服务 ),让开发者可以直接通过 Azure 来调用 API 、微调和部署开源大模型。

现在已经有像 Llama 2 as a Service 、 Mistral as a Service 等模型服务准备上线了。

如果你担心基础模型不会用,微软的 Azure AI Studio 工具链还能从模型的构建、训练推理到评估部署,一条龙全给你安排得明明白白。

摆明了就是在告诉开发者,你们都来用我的 Azure 吧!好东西都在我这了!

有意思的是,这场大会中间还发生了个 " 小插曲 " 。

大伙儿应该也都知道,微软和 OpenAI 一直以来都是好基友的关系,但时不时,总会有一些 " 微软和 OpenAI 相爱相杀 " 的传言流出。

前几天的 OpenAI 开发者大会上,纳德拉作为嘉宾被邀请到了现场,而这次,微软也用一张 "Microsoft ( 爱心 ) OpenAI" 的 PPT 力破传言,高调地秀了一波恩爱。

最后这么说吧,整场大会,世超看到了微软在 AI 领域的自信和决心。

还记得去年 ChatGPT 刚发布的时候,微软还是那个在外界看来跟时代擦身而过的 " 老人 "。

谁也想不到,从年初接二连三宣布要拿生成式 AI 革自家业务的命,不到 1 年的时间里,微软就已经从业务,深入到了整个 AI 链条。

都说船大难掉头,但微软却身体力行地告诉大家,我不仅掉头了,现在船还开得挺稳当。

不得不说,微软这波已经快到大气层了好吧。

责任编辑:

文章来源:http://www.xinwulian.net/news/2023/1117/1654.shtml