首页 > 快讯 港理工团队研发动态视觉传感器,实现低延时低功耗的运动识别

港理工团队研发动态视觉传感器,实现低延时低功耗的运动识别

近日,香港理工大学和华中科技大学教授造出一款动态视觉传感器,实现了高级别的动态视觉处理。

图 | 左二为教授,右一为本次论文第一作者周越博士(来源:资料图)

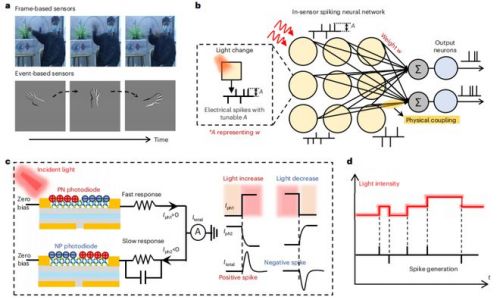

本次研究结合了动态视觉传感器和传感器内计算,通过充分利用两者的优点,他们还设计出一款动态传感器内计算架构。该架构可以大幅提高运算效率,实现低延时、低功耗的运动识别。

(来源:Nature Electronics)

这种直接在传感器内进行实时处理和决策的方式,有望用于边缘计算,以及用于那些对延迟高度敏感的场景比如无人驾驶汽车、机器人技术等领域,并能有效节省通信带宽,此外还能增强数据的安全性和隐私性。

那么,相比现有的图像传感器、或互补金属氧化物半导体(CMOS,Complementary Metal Oxide Semiconductor),动态视觉传感器在捕捉动态图像时,在工作原理上有着哪些不同?

据了解,传统相机所基于的标准图像传感器具有固定的帧率,不管像素点的光强是否发生变化,都会在每一帧记录下所有像素的绝对光强,因此会包含大量冗余的视觉数据。

另一方面,较长的曝光时间限制了事件捕获的延迟,导致所捕捉到的高速运动物体图像存在模糊和过曝等问题。

相比之下,受生物视网膜启发的动态视觉传感器(DVS,Dynamic Vision Sensor),可以只针对场景中的相对变化区域作出反应。

对于动态视觉传感器来说,只有在像素点的位置发生光强变化的时候,才会产生脉冲信号从而生成稀疏数据,这样一来就能大大减少数据的冗余量。

动态视觉传感器还具备超高的时间分辨率,能够确保动作信息被完整记录下来。因此,它也能被用于检测场景中的变化,输出稀疏且重要的信息。

(来源:Nature Electronics)

而对于传感器内的脉冲信号来说,它是否也能被反馈给传感器神经元,从而做出相应的调整?

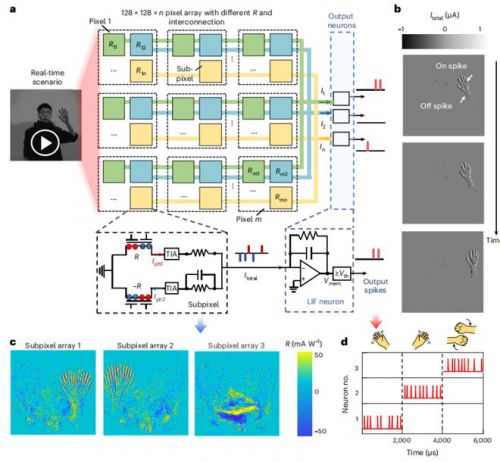

对于这一问题,答案是肯定的。为了执行复杂的计算任务比如动作识别,像素单元需要被扩展到阵列级别,并通过单元之间合适的物理互连,构建成脉冲神经网络(SNN,Spiking Neural Network)。

而每个子像素阵列,在连接之后可以输出神经元。在动态场景中,当像素点的光照强度发生变化时,子像素单元也会产生正负电流脉冲,来对 LIF(leaky integrate and fire)神经元中的电容进行充放电。

一旦电容的积分电压也就是神经元的膜电位,达到神经元的阈值时就会输出脉冲。

让传感器实现更高级的处理功能

据了解,本次研究涉及到了 In-sensor 脉冲神经网络框。那么,它与传统神经网络有何不同?

目前,市面已有的动态传感器在检测光强变化的时候,必须使用光电探测器、电容器、放大器和比较器等复杂的像素电路。

然后,这些模拟信号需要通过模拟数字转换器转化为数字信号,从而被可编程逻辑门阵列标上时间戳,借此产生一系列数字事件比如像素地址、时间信息、光强变化极性等。

这些由模拟数字转换器和可编程逻辑门阵列完成的模拟信号处理步骤,会将动态视觉传感器的时间分辨率限制在几十微秒量级。

而且经过处理之后的数字信号,仍然需要被频繁地传输到基于脉冲的神经形态处理器、或传输到由电子突触构建的脉冲神经网络之中。

数字信号在传感器和处理单元之间的传输,会进一步地把时间分辨率限制在毫秒量级。

相比之下,课题组于 2020 年提出的近传感器计算和传感器内计算架构 [1],能把部分计算任务转移到传感器附近或传感器终端。

通过在传感器终端附近或直接在传感器之内进行数据处理和计算,可以有效减少大规模数据的来回传输,从而提高带宽效率和数据处理效率,进而降低计算功耗和延时。

目前,已有研究证实通过在传感器端口进行预处理,比如增强对比度、减小噪声、视觉自适应调节等方法,可以显著提高图像识别效率。

进一步地,通过利用可调节的光响应度来模拟突触权重,用光探测器来构建人工神经网络,可以实现更高级别的人物静态图像识别,从而实现传感器内计算。

在传统人工视觉系统之中,视觉传感器和计算单元在物理空间上是分立的,且存在较远的物理距离。

随着物联网节点数量的迅速增长,传感器终端和计算单元之间交换着大量的冗余数据。假如使用上述方案的话,每个像素都会针对绝对光强值产生对应光电流值。

而对于动作识别等动态场景,往往缺乏事件触发的特性,所以会产生大量冗余的数据。一般来说,外界的视觉信息先被转换成数字形式,再传到计算单元中做进一步处理和计算。

传感器和计算单元之间大量数据的来回传输,最终会导致高延迟和高功耗。因此,如何通过器件原理与结构设计,在单一器件实现信息原位的传感、处理、存储等多功能集成,借此减少数据传输、降低功耗、减少延迟,是一个亟须解决的科学问题。

事实上为了克服以上问题,该团队已经开展了多年研究。如前所述,课题组已于 2020 年率先提出近传感器计算和传感器内计算架构。

通过在传感器终端附近、或直接在传感器内进行数据处理和数据计算,可以有效减少大规模数据的来回传输,从而提高带宽和数据处理的效率,进而降低计算功耗和延时。

同时,他们还利用动态视觉传感器和传感器内计算架构的优点,开发出一款感算融合脉冲神经网络架构,并将其用于动作识别。

此外,他们还设计了一种基于事件驱动的像素单元,它能在发生光强变化的时候,产生可被编程的脉冲信号。

通过调节光电探测器的光响应度,就能有效调节像素单元产生的脉冲信号的幅度,从而模拟不同的突触权重。

对于这种感算融合脉冲神经网络方案来说,它可以实现低于 20 微秒的时间分辨率,并能通过动作识别的方式,针对智能视觉芯片的潜力加以仿真验证。

后来,课题组又开发出能用于图像预处理和动作预处理的新型传感器,通过抑制不必要的噪声或失真,或通过增强进一步处理的特征,从大量原始数据之中记录和提取有用的数据 [2]。

而为了在传感器内实现更高级的处理功能,他们又以生物视网膜为启发开展了本次研究,即研发具有计算功能的动态传感器。

(来源:Nature Electronics)

具备实现大规模感算融合的潜力

香港理工大学博士后周越,是本次动态视觉传感器的主要设计者。他巧妙结合了动态视觉传感器和传感器内计算的优点,实现了感算融合的脉冲神经网络。

而在 2022 年初,课题组关于动态视觉传感器的第一篇相关论文,已经发布在 2022 年微电子器件领域顶级国际会议 IEEE International Electron Devices Meeting(IEDM)上。

在那篇论文之中,周越利用该团队此前研发的二硫化钼光电晶体管阵列,针对单个器件进行表征和电路测试,借此验证了动态视觉传感器设计方案的可行性。

然而,要想使用二硫化钼光电晶体管实现具有计算功能的动态传感器,依然存在如下问题等待解决:

其一,二硫化钼光电晶体管高的动态范围,来源于其光照强度和光电流的非线性关系。当使用这种晶体管来构建神经网络时,会使用到“光电流=光响应度*光照强度”这样一个公式。

在这个公式里:光照强度是输入矢量, 光电流是输出矢量,光响应度是突触权重矩阵。

因此,课题组原则上希望光响应度,不会随着输入量的光照强度发生改变,也就是光响应度和光照强度之间要能够满足线性关系。

其二,对于二硫化钼光电晶体管来说,它需要在不同的栅极偏置之下实现不同的光响应度。在恒定栅压的施加之下,计算功耗开始增大。而且需要额外的内存单元,来储存每个光电晶体管所需的施加栅压。

其三,二硫化钼光电晶体管的响应时间为 10ms,这导致时间分辨率只能限制在毫秒量级。

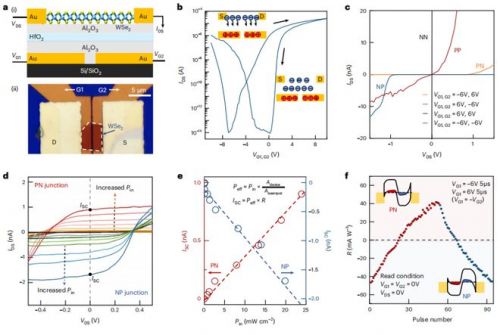

鉴于上述问题,周越设计了非易失的光电二极管器件。这种光电二极管中的光照强度和光电流的线性关系,使其更适合用来实现感算融合。

而且相比光电晶体管,光电二极管的光伏效应让其光响应速度得到大幅度提升。

进一步地,周越通过采用浮栅层的设计,让电荷可以被长时程地储存在浮栅层。

这样一来,即使在没有外部电压偏置的情况下,也能实现不同的光响应度。相比之下,光电晶体管则需要恒定的施加外部电压。

由此可见,周越所使用的这种方式可以有效减少能耗,同时具有更强的扩展性,在被用于更大神经网络的同时,还能避免出现走线施加外部偏压的风险。

基于此,周越等人制备了基于二硒化钨的浮栅二极管,并对其进行电路级别的光电测试。

华中科技大学教授课题组的付嘉炜同学,则负责进行网络级别的动作识别仿真。利用自制的动作数据集,证实本次设计方案具备实现大规模感算融合的潜力。

最终,相关论文以《用于神经网络内传感器的计算机事件驱动视觉传感器》()为题发在 Nature Electronics(IF 34.3),周越是第一作者,和担任共同通讯作者 [3]。

图 | 相关论文(来源:Nature Electronics)

力争让传感器阵列与外围电路实现大规模集成

如前所述,本次研究使用了二硒化钨光电探测器,那么它是如何实现可编程的?

对此,课题组表示之所以选用二硒化钨作为沟道材料,是因为其具有比较均衡的能带结构,容易被电场调节为 n 型或者 p 型,从而具有双极性。

另外,二硒化钨作为具有原子级别厚度的半导体,具有较强的光-物质相互作用。

通过对两个分立的背栅分别施加正负电压,即可调节储存在浮栅层HfO 2 的电子数量和空穴数量。

进而诱导沟道二硒化钨左右两个区域的载流子类型和浓度,就能形成具有不同整流效应的 PN 结或 NP 结,从而产生可调节的正负光响应度。

那么,在动态图像识别过程中,基于二硒化钨的响应时间是否可以满足要求?

对于这一问题该团队表示,光的照射会激发电子空穴对的产生,并被二硒化钨构成的 PN 结和 NP 结的内建电场所分开。

因此,即使在零偏压的情况下,基于二硒化钨的 PN 或 NP 结,也会产生自驱动短路光电流 ISC。值得注意的是,该电流具有微秒级别的响应时间。

对于传统计算架构来说,它需要在传感单元和计算单元之间来回传输,这会催生毫秒级别的延迟。

而该课题组的感算融合方案,可以直接在传感器内执行计算,其动作识别的延迟仅局限于二硒化钨的响应时间,故能产生微秒级别的超高分辨率,实现快速动态的识别。

不过,受限于目前的测试设备,当下只能测试微秒级别的时间分辨率,但是本次器件的理论响应速度可以达到纳秒级别。

同时,当前的研究仍然局限于器件层面和较小的 3*3 阵列。未来,课题组希望进一步扩展,实现系统级别的展示。

另一方面,虽然二维半导体已经取得不错的进展,但是仍然存在均一性和稳定性的问题。

更重要的是,关于二维材料器件和互补金属氧化物半导体工艺的兼容问题仍然需要取得进一步突破。

因此在底层硬件层面:该团队将通过采用目前比较成熟的光电传感器工艺,进行大规模传感器阵列的制备;

而在顶层算法层面,他们将开发适配感算融合架构的算法。

未来,课题组希望能实现传感器阵列与外围电路大规模集成,展示其在实时和数据密集型应用中的优势。

参考资料:

1.Nature,2020, 579, 32-33; Nature Electronics, 2020, 3, 664-671

2.Nature Nanotechnology, 2023, 18, 882-888;Nature Electronics,2022, 5, 84-91

3.Zhou, Y., Fu, J., Chen, Z.et al. Computational event-driven vision sensors for in-sensor spiking neural networks. Nat Electron 6, 870–878 (2023). https://doi.org/10.1038/s41928-023-01055-2

责任编辑:

文章来源:http://www.xinwulian.net/news/2023/1130/1793.shtml